Par Monique Savoie pour Observateur-Continental

Un débat s’est enflammé dans la Silicon Valley sur l’aspect moral de doter l’IA intégrée dans l’armement de la capacité de prendre des décisions de tuer.

Dans la Silicon Valley, les fondateurs d’entreprises développant des technologies militaires utilisant l’intelligence artificielle (IA) ont débattu de l’acceptabilité de franchir une limite critique, à savoir autoriser les technologies d’IA à prendre des décisions autonomes de tuer.

En septembre, le cofondateur de Shield AI, Brandon Tseng, a déclaré que les armes aux États-Unis ne deviendraient jamais complètement autonomes où l’IA prendrait la décision finale de tuer. Il était convaincu que ni le Congrès ni le public ne soutiendraient une telle idée. Cependant, quelques jours plus tard, le cofondateur de la société Anduril, Palmer Luckey, a remis cela en question, soulevant l’aspect moral de l’opposition aux armes autonomes. Il a affirmé que les mines incapables de distinguer les civils des soldats ennemis pourraient être plus dangereuses que les systèmes contrôlés par l’IA.

Lorsqu’on lui a demandé des éclaircissements, l’entreprise a précisé que Luckey ne préconisait pas que les robots prennent eux-mêmes des décisions de vie ou de mort, mais exprimait son inquiétude quant à une possible mauvaise utilisation de l’IA. Son collègue Trae Stephens avait précédemment souligné l’importance du contrôle humain dans la prise de décisions concernant l’utilisation d’armes létales. Anduril affirme que les deux positions sont alignées, car la responsabilité est importante, même si chaque décision n’est pas prise directement par un humain.

La position du gouvernement américain sur les armes autonomes est également ambiguë. Les militaires américains n’achètent pas d’armes létales entièrement autonomes, mais n’interdisent pas aux entreprises de les développer ou de les vendre à l’étranger. Les États-Unis ont introduit des recommandations volontaires sur l’utilisation de l’IA à des fins militaires, nécessitant l’approbation des plus hauts gradés militaires pour les nouveaux systèmes autonomes, mais ces règles ne sont pas obligatoires. Les responsables américains déclarent constamment que « Not the right time » (ce n’est pas le moment) d’envisager une interdiction obligatoire des armes autonomes.

Joe Lonsdale, cofondateur de Palantir et investisseur chez Anduril, a critiqué les discussions actuelles sur une interdiction totale des armes autonomes, proposant ce qu’il considère comme une approche plus flexible. Il a appelé les politiciens à mieux comprendre les nuances de l’IA dans les systèmes militaires avant de prendre des décisions qui pourraient affaiblir les capacités de défense des États-Unis.

Sachant qu’Anduril et Palantir insistent sur le fait que la politique doit être déterminée par des élus, et non par les entreprises elles-mêmes. Cependant, ils soulignent également que les législateurs doivent comprendre la complexité de l’IA dans les conflits militaires. Beaucoup dans la Silicon Valley et à Washington craignent que la Chine ou la Russie ne commercialisent en premier des armes entièrement autonomes, forçant les États-Unis à faire de même.

Des activistes et des groupes de défense des droits de l’homme ont longtemps essayé, sans succès, d’établir des interdictions internationales sur les armes létales autonomes, des interdictions que les États-Unis ont refusé de signer. La guerre en Ukraine a probablement fait basculer la situation contre les activistes, fournissant à la fois une source de données de combat et un champ de bataille pour tester les technologies de défense. Actuellement, les entreprises intègrent l’IA dans les systèmes d’armement, bien qu’elles exigent toujours qu’un humain prenne la décision finale de tuer.

Pendant ce temps, les responsables ukrainiens insistent sur une plus grande automatisation des armements, espérant que cela leur donnera un avantage sur la Russie.

« Nous avons besoin d’une automatisation maximale. Ces technologies sont fondamentales pour notre victoire », a déclaré le ministre ukrainien de la Transformation numérique, Mykhaïlo Fedorov, dans une interview au New York Times.

Monique Savoie

Tous les articles, la tribune libre et commentaires sont sous la responsabilité de leurs auteurs. Les Moutons Enragés ne sauraient être tenus responsables de leur contenu ou orientation.

La suite, à rebours, de « JB 007 » est logiquement « IA 007 ».

Blog : https://livresdefemmeslivresdeverites.blogspot.com/

La pseudo-« intelligence artificielle » n’est que la prolongation plus ou moins heureuse de la programmation d’un ou plusieurs tapeurs d’écrans plus ou moins imbus de leur supériorité. L’intelligence, souvent, est justement l’art, à partir de données souvent partielles, de CRÉER un résultat nouveau, inattendu ; l’IA va chercher dans toutes ses données celles qui seront les plus proches du meilleur résultat, mais cela peut être décevant, immédiatement ou plus tard, par manque justement de créativité.

Un exemple « inventé » sur l’instant ? Travaillant sur l’écologie, l’IA va décréter que sur telle surface il y a 200 mille humains, ou buffles, ou autres (quelle importance ?) en trop, et immédiatement va œuvrer pour rectifier le tir. Un vrai humain inventif va trouver tout autre chose. On notera que »nos chers politiciens » vont travailler sans chercher à comprendre dans le sens de l’IA, parce qu’ils ne sont plus des humains. D’où au hasard la mise en place du Covid, qui était dans les cartons depuis longtemps.

.

Il serait sans doute souhaitable que des tests permettent d’écarter les candidats aux élections de haut niveau (à partir de maires de villes de plus de 20 000 habitants), mais aussi les hauts fonctionnaires AVANT leur mise en place à tel ou tel poste.

Comme vous le dites , » l’intelligence, souvent, est justement l’art, à partir de données souvent partielles, de CRÉER un résultat nouveau, inattendu » Au lieu d’être toujours les victimes de l’IA militaire , les pauvres civils sont donc en droit d’exercer leur droit de défense , à savoir de mettre au point une IA de retour sur l’envoyeur , sous une forme ou sous une autre , des décisions et des manoeuvres mortifères de décideurs nationaux ou étrangers qui ont perdu tout sens moral , toute humanité .

Dans un futur assez proche, l’IA sera probablement interdite, en particulier par respect pour l’intelligence ‘naturelle’ et humaine.

Pour ceux qui sont pressés d’en découdre avec une saloperie de machine, de type IA ou non, il y a toujours la peinture à l’huile mélangé à du sable ou de la litière à chat, pour gripper un peu la ‘bête’

– Un humanoïde AI n’est point un bipède hyper fragile comme l’est l’homo-sapiens.

…Qui a la fragilité d’un jeune chevreuil

– A ce titre , sur un robot chaque articulation est évidemment protégée des agents extérieures par des soufflets ou des joints à lèvres.

– De plus, sa vision peut être thermique et donc, totalement insensible à toute perturbation du type peinture et autres qui seraient projetés sur ces capteurs.

…Et oui, va falloir apprendre à n’être plus indispensable à « notre élite ».

Bonjour Engel … qui est un des être les plus fragiles sur Terre. Sans notre intelligence/créativité nous ne serions sans doute pas la race dominante.

qui est un des être les plus fragiles sur Terre. Sans notre intelligence/créativité nous ne serions sans doute pas la race dominante.

Bonne comparaison, avec l’humain

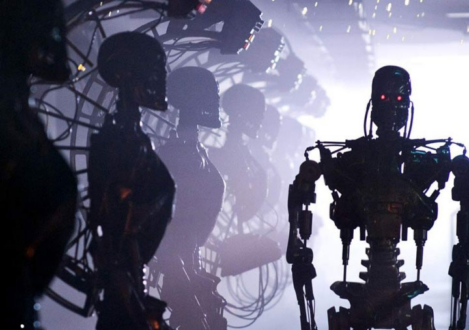

Pour la peinture et le sable pour gripper une mécanique, je ne m’attends pas à ralentir un futur Terminator mais ces petites bêtes n’aiment pas l’électricité.

mais ces petites bêtes n’aiment pas l’électricité.

Soit un choc d’électricité statique que l’on peut créer chez-soi(je ne sais pas si ça fonctionnerait), ou une pique à vache(bâton électrique), mais il faut s’approcher.

Nous ne sommes que des ‘tubes digestifs’ pour nos maîtres …

Bien sûr que l’A.I va être autorisée à tuer.

…Que cela plaise ou non.

Totalement d’accord.

Ca commencera sans doute par un méchant pays sans morale avec un dictateur à sa tête, et puis les autres suivront en prétendant que leur IA à eux est beaucoup plus performante et ne fait pas d’erreurs ni de victimes innocentes.

Je m’attend aussi sans doute en premier lieu, à un remake de Robocop, avec des robots policiers équipés d’armes « non létales », comme des lbd et autres tazers… Ca aidera probablement à faire des tests et à faire accepter plus facilement le principe aux citoyens…

Moi je parierai plutôt sur des mécanismes(fixes ou mobiles) de gardiennage de frontières, avec surveillance et ouverture du feu gérées par A.I.

Ou bien des dromes vagabonds autonome au dessus du champs de bataille à la recherche d’une cible ennemi.

Pour les deux cas nous y sommes déjà…presque dirais-je, pour être pas trop anxiogène…)

Coucou !

Meilleurs exemple de robot à IA tueur vu au cinéma :

Et surtout réaliste…

Akasha.

Rebonjour … le drone aérien est celui qui sera le plus difficile à contrer, sinon avec des filets.

Au sol, aucune machine ne peut rivaliser avec l’humain. On pourra toujours l’empêcher d’avancer.

Certes, mais cela s’appelle une guerre.

La Silicon Valley qui se pose une question éthique ? Ca alors !

Les enfants de cette « entreprise » n’ont pas de portable. C’est déjà un signe qu’elle sait ce qu’elle fait. Là, il s’agit de tuer ? Disons que c’est plus brutal, mais les ondes tuent aussi.

Et pas de souci: en admettant qu’elle refuse cette potentialité, d’autres de part le monde ont déjà créé les robots tueurs. Et puis, un drone, qu’il y ait un individu au bout ou non, c’est un robot tueur.

Que craint-on, la bavure ??? Je sens que je vais éclater de rire … Si si !

Ho Biquette ! Mon fils a un drone , pour faire des panoramiques « depuis là-haut » ! Ce n’est pas un robot tueur, sauf s’il tombait brutalement, mais même là il y a des sécurités.