Si Google se met à évaluer les pages web selon leur prétendue « véracité », c’en est fini de la neutralité du net

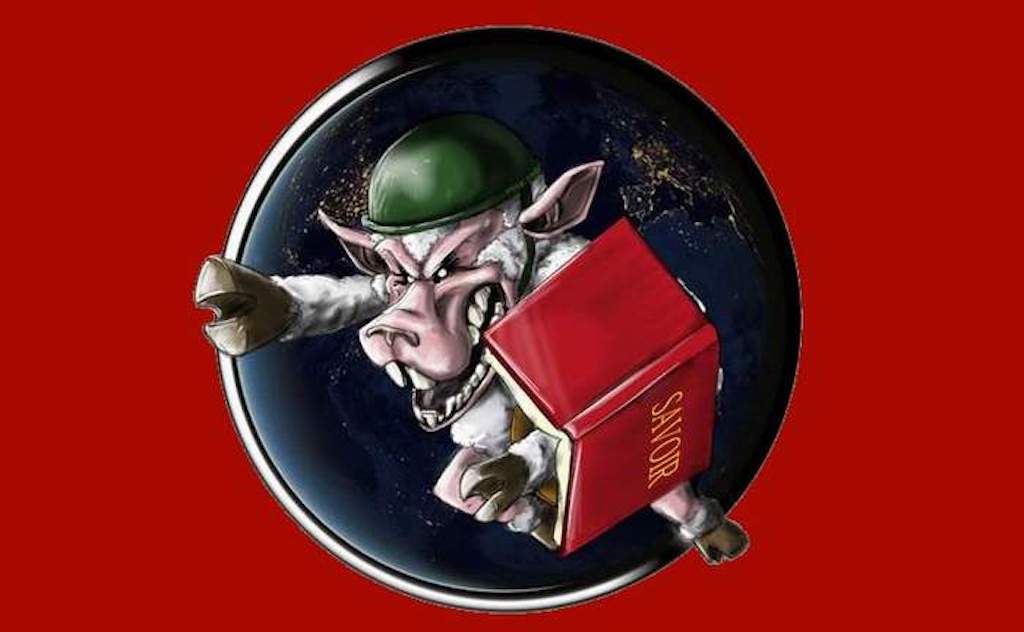

Je vous livre tel quel, ci-dessous, l’article de NewScientist. Il fait la promotion du nouveau programme de Google qui doit, à terme, remplacer le Page rank, c’est-à-dire, l’algorithme de classement des résultats de recherche basé sur la popularité des pages web. Le projet est digne du ministère de la vérité du roman « 1984 » ; en effet Google préconise dorénavant de classer les pages et les sites webs en fonction de la « véracité » des informations qu’ils contiennent afin de lutter contre « la désinformation ». Si ce projet voit le jour, c’en est fini de la neutralité du web ; cela conduira à l’imposition d’une vérité unique fondée sur le consensus, c’est à dire sur la capacité à imposer une perception, un concept ou une représentation du monde au plus grand nombre : la capacité d’influencer l’opinion publique sera déterminante (comme si elle ne l’était pas déjà suffisamment…)

Concrètement, la puissance de feu médiatique des grands groupes de presse, des lobbies et des responsables politiques deviendra la mesure essentielle de la « vérité » selon Google. Evaluer la « vérité » renvoie en soi à une conception totalitaire et archaïque du savoir et de la connaissance : au niveau scientifique, l’évolution de la recherche et des connaissances conduit à remettre continuellement en cause les vérités jusque-là consensuelles et établies. Le savoir et la connaissance ne sont ni des données acquises ni des données figées. Songeons à la révolution copernicienne ou à la théorie de la relativité générale, ou plus récemment encore à la physique quantique. Ces révolutions scientifiques majeures se sont imposées contre la physique traditionnelle et ont conduit à la remise en cause massive des conceptions scientifiques antérieures. Les percées scientifiques de Copernic, Einstein ou Schrödinger auraient donc été classées par Google comme de la désinformation et du contenu « poubelle »…

Google veut classer les pages web en se basant sur leur contenu et non pas sur leur popularité

Par Hal Hodson | 28 Février 2015 – Newscientist.com

La véracité d’une page web pourrait la faire remonter dans le classement de Google si le moteur de recherche met en place une mesure de la qualité basée sur les faits et non plus sur la popularité.

Internet est rempli d’ordures. Les sites web anti vaccination apparaissent en première page de Google et les articles aux contenus farfelus se répandent comme des feux de forêt. Google a mis au point un correctif pour classer les sites web selon leur véracité. Le moteur de recherche utilisait jusqu’à présent une méthode de classement basée sur les liens entrant sur les pages web, comme valeur d’approximation de leur qualité, déterminant leur place dans les résultats de recherche. Les pages qui bénéficiaient ainsi de nombreux liens entrants étaient classées plus haut. Ce système a fait le succès du moteur de recherche mais le problème de cette méthode c’est que les sites Internet truffés de désinformation pouvaient atteindre le haut du classement lors d’une recherche si suffisamment de gens y faisaient référence.

Une équipe de recherche de Google est en train d’adapter ce modèle afin de mesurer la véracité d’une page plutôt que sa popularité sur Internet. Plutôt que de comptabiliser les liens entrants, le système, qui n’est pas encore opérationnel, comptabilisera le nombre de faits incorrects présents sur la page.

« Une source qui comprend peu de faits erronés est considérée comme fiable » avance l’équipe de Google. Le score qu’ils calculent pour chaque page est le score de confiance basé sur les connaissances.

Le programme fonctionne en se référant au Knowledge Vault, une vaste base de données de faits que Google a compilée sur Internet. Des faits auxquels le web adhère de manière unanime et qui sont considérés comme une approximation raisonnable de la vérité. Les pages web qui contiennent des informations contradictoires sont ainsi rétrogradées dans le bas du classement.

Il existe déjà de nombreuses applications destinées à aider les internautes à évaluer la vérité. Lazy Truth est une extension de navigateur qui aide les boîtes de réception à éliminer les fake ou les hoax parmi les emails. Emergent, un projet du Centre Tow pour le digital-journalisme de l’université de Columbia, recense les rumeurs provenant des sites poubelles et les vérifie par le référencement croisé avec d’autres sources.

Le développeur de Lazy Truth, Matt Stempeck, qui est maintenant directeur du département des médias civiques chez Microsoft, souhaite développer des programmes pour exporter le savoir basé sur des services de fact-checking, comme Snopes, PolitiFact, et FactCheck.org, afin que tout le monde puisse y accéder facilement. Il affirme que des outils comme LazyTrust sont extrêmement utiles, mais que lutter contre les croyances erronées qui sous-tendent la désinformation est plus compliqué. « Comment corriger les conceptions erronées des gens ? Les gens adoptent à ce sujet des positions très défensives. Alors que s’ils cherchent une réponse sur Google, ils seront beaucoup plus réceptifs. »

Hal Hodson | 28 Février 2015

Traduction et commentaire : Guillaume Borel

Publication originale : Arrêt sur info

Et arreter d’utiliser google?

Vous pouvez utiliser d’autres moteurs peut etre un peu plus lents, mais est ce que trois secondes de plus vous empechera de vivre?

Duckduckgo, startpage, yandex moteur russe, yacy moteur decentralisé ?

il y a aussi un méta moteur performant. Copernick.

Vous etes aussi responsable de ce qui vous arrive. ne vous laissez pas entrainer dans la facilité pour venir ensuite vous plaindre. Il en est de meme pour les FAI.

La FDN fournit des acces concurrentiels mais des prix justes. pas des prix subventionnés par la pub. Plus vous serez a y adherer plus les prix baisseront.

Google est de plus en plus contrôlé par l’intelligence artificielle. A terme, ils veulent que ce soit l’I.A. qui détermine ce qui doit être perçu comme vrai ou faux.

Les gens sont libres d’utiliser le moteur de recherche qu’ils veulent. La solution: briser sa dépendance envers Google comme moteur de recherche. J’aime beaucoup Google pour sa puissance de calcul et pour sa fiabilité multi-informative voire contre-informative c’est-à-dire justement sa capacité à présenter aussi les résultats qui remettent en question la pensée consensuelle.

Donc s’ils choisissent de régresser, bien ça veut dire qu’il faudra aller voir ailleurs, car je n’ai pas besoin d’être nourri par les mensonges de la pensée unique, compilés par une I.A.

L’intelligence humaine consciente est un gogol de fois supérieure à l’intelligence artificielle de Google.

Résumons:

– Dommage que Google n’existait pas au XVII°siècle. La terre serait toujours plate. 🙁

Effectivement, arrêter Google est peut-être une solution.

Il est également possible, lors d’une recherche google, d’aller directement à la page 5 ou 10 des résultats pour trouver des articles moins « vrais » mais plus populaires.

Si on tombe vraiment dans l’extrême, ma réponse le sera tout autant : adieu les moteurs de recherche et peut-être bien adieu le net.

Si ce projet voit le jour, c’en est fini de la neutralité du web ; cela conduira à l’imposition d’une vérité unique fondée sur le consensus.

Mais non ! par tout les moyens on essaie de nous formater à une vérité unique mais ça ne marchera pas, tout simplement parce que de plus en plus de gens sentent qu’on leur ment même s’il reste encore des naïfs sur cette terre pour les croire, la situation est en train de s’inverser.

D’après vous, pourquoi mettent-ils de plus en plus d’énergie à détourner le moutons de la vrai information si ce n’est par crainte de ne plus être crédible aux yeux de tous et de perdre le pouvoir sur les foules.

Les bonimenteurs qui meurent à petit feu, savent qu’actuellement l’être humain se détache de plus en plus de leur autorité et commence à trop réfléchir par lui même, la pensé unique va disparaitre car aujourd’hui l’homme est dans une phase d’évolution de sa conscience qui le rends de plus en plus autonome dans sa pensé.

Si ces messieurs de Google me lisent, qu’ils se rassurent, toutes démarches en ce sens seront vaines, ils feraient mieux de donner leur énergie à transmettre les vraies informations salutaires à leur âme en perdition et comprendre que la vérité patiemment ressurgira toujours en première page du web dans le classement des pages les plus populaires.

Les pages des médias alternatifs sont déjà très mal référencées par rapport à la presse mainstream, à part ER, si le nouvel algorithme s’applique, les sujets « populaires » sur lesquels ils ont une visibilité, comme les sites anti-vaccination donnés en exemple dans l’article, seront pour le coup encore plus mal référencés, c’est à dire qu’il faudra probablement aller fouiller dans les profondeurs des pages de résultat pour les trouver. Adieu donc leur visibilité.

Comme le dit la citation à la fin de l’article de NewScientist, le but est bien de « rectifier les conceptions erronées », c’est à dire d’imposer la pensée unique sur le net.

Il ne tient qu’a mous de les referencer correctement.

Yacy n’est pas fait pour les chiens.

Mais il n’y a pas que google dans la vie !

J’utilise le moteur de recherche et le navigateur Yandex en français et il me trouve tout ce que je veux aussi bien que Google ! Et en plus c’est russe

Tiens?

Un juju rus(s)é

Quoi de plus naturel quand on est « une » Juju

« Si Google se met à évaluer les pages web selon leur prétendue « véracité » »…..ben y a qu’a commencer par les dernières . Une page mal classée va donc devenir un gage de qualité . Ça aura au moins l’avantage de nous permettre de zapper rapidement les sites d’infox qui vont se retrouver en tête de liste.

Et pendant ce temps : Première fermeture administrative de site

http://www.valeursactuelles.com/societe/la-france-bloque-un-site-dapologie-du-djihad-51396

L’intérieur veut aider Google, en s’en servant.

Aujourd’hui il traque les terroristes.

Demain il traquera les terroristes (que vous serez devenus) comme hier il aurait traqué ceux de l’époque (les parents et grand parents de certains d’entre vous. Rassurez vous, ils ne l’étaient pas tous puisque selon Amouroux, ils étaient 40 millions de collabo).

On « redirige » toujours sur le droit chemin…. Du moins telle est la volonté déclarée, car la secrète….

https://launedekeg.wordpress.com/2015/03/17/keg-ce-17032015-larticle-21-en-reponse-au-16-la-liberte-citoyenne/